Действительно ли обнаружение «материалов, описывающих сексуальное насилие над детьми» от Apple служит своей первоначальной цели?

Apple ввела новый набор технологических мер для предотвращения жестокого обращения с детьми. Машинное обучение будет использоваться в настройках подписки в семейных учетных записях iCloud для обнаружения любой обнаженной натуры на изображениях. Система блокирует получение или отправку таких снимков, отображает предупреждения и предупреждает родителей о том, что ребенок их отправил или просмотрел.

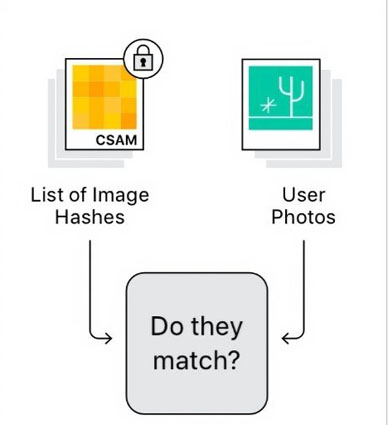

Apple пояснила, что ни одна из этих функций не ставит под угрозу конфиденциальность пользователей при работе с CSAM. Для механизма обнаружения iCloud будет использоваться умная криптография, чтобы предотвратить доступ механизма сканирования к любым изображениям, не являющимся CSAM. Apple уверена, что новая система может сыграть значительную роль в эксплуатации детей, поскольку она может нарушить любые хищнические сообщения, и она включает поддержку ряда экспертов по криптографии.

- Часть 1. Что такое обнаружение «материалов, описывающих сексуальное насилие над детьми» от Apple?

- Часть 2: Почему обнаружение «материалов, описывающих сексуальное насилие над детьми» от Apple является спорным?

- Часть З: Могу ли я остановить обнаружение «материалов, описывающих сексуальное насилие над детьми»?

- Часть 4: Каков последний ответ Apple на CSAM?

Часть 1. Что такое обнаружение «материалов, описывающих сексуальное насилие над детьми» от Apple?

В основном, Apple анонсировала три отдельных обновления, и каждое из них связано с безопасностью детей. CSAM является наиболее важным из этих обновлений, так как он был в состоянии получить много внимания, и это особенность, которая может сканировать iCloud фотографии. Эта функция позволяет сравнивать изображения пользователей с базой данных ранее идентифицированных материалов. Процесс обзора запускается при обнаружении ряда конкретных изображений.

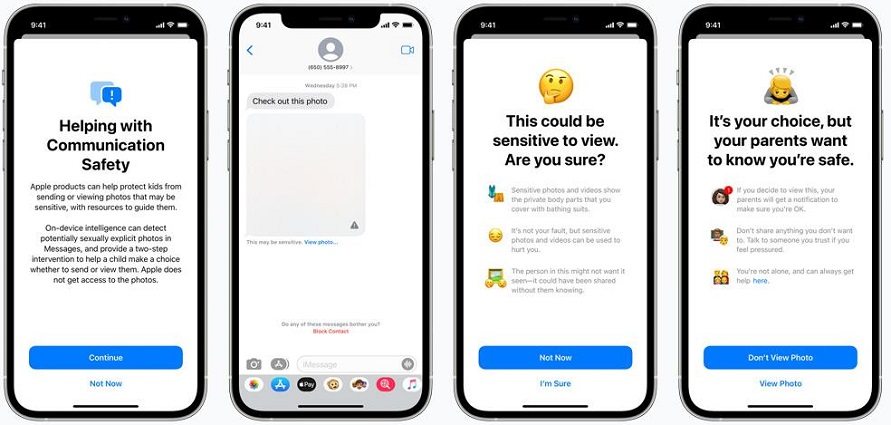

Apple приостановит действие учетной записи iCloud, если изображения будут проверены рецензентами, и об этом будет автоматически сообщено в NCMEC или Национальный центр пропавших без вести и эксплуатируемых детей. В приложении сообщений также есть функции безопасности общения, которые позволят ему определять, когда какие-либо фотографии отправляются или получаются детьми сексуального характера.

При получении явного изображения приложением сообщений будет предупреждение для детей старше 13 лет. Помимо этого, Apple также обновляет свои исследовательские возможности и Siri, чтобы вмешиваться в запросы, касающиеся CSAM. Siri сможет предоставить ссылки на ресурсы, если нужно знать, как сообщить о злоупотреблениях.

Часть 2: Почему обнаружение «материалов, описывающих сексуальное насилие над детьми» от Apple является спорным?

Хотя многие люди в основном согласны с тем, что эта конкретная система имеет надлежащие ограничения по объему, ряд наблюдателей, экспертов и защитников конфиденциальности в основном обеспокоены возможностью злоупотребления системой. Ряд поставщиков облачных хранилищ, таких как Microsoft и Dropbox, уже выполняют обнаружение изображений на своих серверах. Поэтому многие люди соглашаются и не согласны и даже думают о переходе на телефоны Android, если дела продолжатся. Также есть различные споры по поводу Apple CSAM; Итак, разные люди дали смешанные отзывы.

1. Люди, которые согласны

- Бенни Пинкас, криптограф израильского университета Бар-Илан, считает, что система PSI от Apple предлагает превосходный баланс между полезностью и конфиденциальностью. По его мнению, идентификация любого содержимого CSAM при сохранении конфиденциальности пользователя и минимальном количестве ложных срабатываний может быть конструктивным.

- Джули Кордиа, генеральный директор группы защиты детей под названием Thorn, считает, что этот шаг Apple помогает приблизить людей к правосудию, особенно для тех выживших, чьи травматические моменты были распространены в Интернете.

- Криптографы и компьютерные ученые, такие как Дэвид Форсайт, Дэн Боне и Михир Белларе, считают, что эта система может значительно повысить вероятность того, что разные люди будут иметь или использовать CSAM. Таким образом, безобидные пользователи будут испытывать минимальную потерю своей конфиденциальности.

2. Люди, которые не согласны

- Надим Кёисси - криптограф и основатель фирмы, известной как Symbolic Software. Для Коэсси идея о том, что ваше личное устройство сканирует и отслеживает вас на основе некоторых критериев нежелательного контента, а затем сообщает об этом властям, может быть довольно скользкой темой.

- Кендра Альберт, инструктор Гарвардской клиники кибер-права, выразила обеспокоенность по поводу уведомлений. Она считает, что это может привести к появлению детей-гомосексуалистов или трансгендеров, поскольку их родителей будут поощрять слежку за ними.

- Профессор Стэнфордской интернет-обсерватории Алекс Стамос ставит под сомнение способность Apple работать с сообществом специалистов по шифрованию. Он думает, что Apple ворвалась в дебаты о балансе и загнала людей в самые дальние уголки без обсуждения или публичных консультаций.

3. Другие споры о CSAM Apple

В Принстонском университете есть два академика, которые утверждают, что они определенно считают CSAM от Apple уязвимым, поскольку они ранее разработали такой. По их словам, система работала точно так же, но они быстро обнаружили явную проблему.

- The Washington Post опубликовала передовую статью, в которой несколько исследователей утверждают, что они потратили два года на разработку CSAM, подобного Apple. История приняла довольно драматический поворот после того, как Apple признала, что она управляет CSAM в течение последних трех лет. Поэтому они считают это серьезным предупреждением для миллионов пользователей Apple iPhone.

Часть З: Могу ли я остановить обнаружение «материалов, описывающих сексуальное насилие над детьми»?

Многие пользователи iPhone и iPad могут быть обеспокоены функцией обнаружения, которая может скоро появиться, когда произойдет следующее крупное обновление iOS и iPadOS. По-прежнему существует возможность запретить Apple сканировать чьи-либо личные фотографии. Стоит отметить, что этот инструмент CSAM просматривает только те изображения, которые вы загружаете в iCloud. Чтобы прояснить ситуацию, никакие фотографии не будут сканироваться системой обнаружения, которую пользователь будет отправлять через приложения с сквозным шифрованием, такие как Whatsapp или Telegram. Но все же это может противоречить ранним предупреждениям, в которых говорится, что он может проникнуть в сквозное шифрование, что сделает его правильной функцией.

Если вы уже синхронизировали фотографии с iCloud и хотите, чтобы средство обнаружения не сканировало фотографии, вам необходимо выполнить следующие действия:

- Вы можете начать с приложения Открытые настройки, а затем перейти в раздел Фотографии.

- Вам нужно будет включить iCloud фотографии, чтобы отключить синхронизацию этих фотографий в облако.

Для того, чтобы получить информацию из библиотеки iCloud, вам просто потребуется нажать на 'Скачать фотографии и видео'.

Часть 4: Каков последний ответ Apple на CSAM?

Apple категорически отрицает ущемление конфиденциальности или возврат к любым предыдущим обязательствам. Второй подробный документ был опубликован компанией, в котором рассматривается большинство претензий. Apple по-прежнему подчеркивает, что сравнивает фотографии пользователей только с любыми известными материалами, посвященными эксплуатации детей. Таким образом, отчет не будет запущен, если есть фотографии собственных детей.

Apple также четко заявила, что вероятность ложного срабатывания составляет один к триллиону, если учесть тот факт, что для запуска обзора необходимо обнаружить определенное количество изображений. Хотя Apple не предоставила сторонним исследователям много информации о том, как все это работает, в основном они говорят, что нам нужно поверить им на слово.

Кроме того, Apple заявляет, что ручная проверка полагается на людей, проверяющих, и может определить, был ли CSAM на устройстве из-за какой-либо злонамеренной атаки. Компания будет отказываться сотрудничать с правительствами и правоохранительными органами, потому что в прошлом многие учреждения просили их внести изменения, ухудшающие конфиденциальность пользователей.

Заключение

В течение последних нескольких дней Apple продолжает вносить ясность в отношении анонсированной функции обнаружения CSAM. Было ясно сказано, что CSAM применяется только к фотографиям, хранящимся в iCloud, а не к видео, в то время как компания также защищает свою реализацию CSAM как обеспечивающую конфиденциальность и сохраняющую конфиденциальность по сравнению с другими компаниями, которые ее предлагают. Тем не менее, компания также признала, что в будущем можно сделать гораздо больше, и планы могут расширяться и развиваться с течением времени. Со временем появятся дальнейшие объяснения CSAM, так что мы можем дождаться их большей ясности.

Мы ценим ваше мнение о последних разработках, касающихся обнаружения «материалов, описывающих сексуальное насилие над детьми», которые сделала Apple, и поэтому мы хотели бы, чтобы вы оставили ниже свои комментарии относительно обновлений Apple по безопасности детей.

Выскажите своё мнение

Оставить комментарий

Оставьте свой отзыв о статьях Tenorshare

Tenorshare UltData

Лучшее программное обеспечение для восстановления данных iPhone

Высочайшая скорость восстановления данных